Generative KI: Vertrauenskrise für Agenturen und Unternehmen

Zuletzt aktualisiert am 10. Oktober 2025 um 08:15 Uhr.In der Welt der professionellen Kommunikation sorgt ein aktueller Vorfall für Aufsehen: Ein renommiertes Beratungsunternehmen erstattet der australischen Regierung einen Teil des Honorars zurück, nachdem ein Bericht mit gravierenden inhaltlichen Fehlern öffentlich wurde. Die Fehler resultierten aus dem Einsatz generativer KI, deren Ergebnisse unbemerkt in den finalen Report eingeflossen waren. Die Öffentlichkeit, Fachmedien und Branchenexperten diskutieren seitdem intensiv, wie künftig mit dem Einsatz von KI in der Kommunikation umzugehen ist. Diese Entwicklung ist kein reiner Einzelfall. In Agenturen und Kommunikationsabteilungen wächst das Bedürfnis nach Transparenz und Sicherheit beim Einsatz neuer Technologien. Digitale Tools und KI-gestützte Systeme werden im Arbeitsalltag immer wichtiger mit ihnen steigen aber auch die Anforderungen an Kontrolle, Nachvollziehbarkeit und Verantwortlichkeit.

Neue Herausforderungen für den Alltag in Kommunikationsabteilungen

Die Diskussion um generative KI und ihre Auswirkungen auf den Berufsalltag ist für Kommunikationsprofis relevant, da sie unmittelbar die Qualität von Reports, Analysen und Strategien beeinflusst. Gerade dort, wo Entscheidungen auf Basis von Daten und Empfehlungen getroffen werden, steht die Integrität der Inhalte im Fokus. Der Einsatz von Technologien wie ChatGPT, Gemini oder vergleichbaren Lösungen ist längst Alltag doch wie lässt sich sicherstellen, dass Ergebnisse verlässlich, nachvollziehbar und korrekt sind?

In Kommunikations-, Marken- und Digitalagenturen wird häufig mit komplexen Daten, Studien und Reports gearbeitet. Der Vorfall um die fehlerhafte Studie zeigt, dass menschliche Kontrolle weiterhin notwendig bleibt. Gleichzeitig wächst der Druck, effizient zu arbeiten und Budgets einzuhalten. Hier entsteht ein Spannungsfeld zwischen Automatisierung und Qualitätssicherung, das neue Prozesse und Methoden erfordert.

Unvollständige Kontrolle: Risiken beim Einsatz generativer KI

Ein zentrales Risiko bei der Nutzung generativer KI ist das sogenannte „Halluzinieren“: KI-Modelle liefern scheinbar plausible, aber frei erfundene Informationen. Im Fall der australischen Regierung wurde ein Bericht eingereicht, der mit erfundenen Zitaten und Quellenangaben versehen war. Die Fehler blieben zunächst unbemerkt, erst aufmerksame Wissenschaftler deckten die Unstimmigkeiten auf. Die Reputation des Unternehmens litt massiv, ebenso das Vertrauen des Auftraggebers in externe Dienstleister.

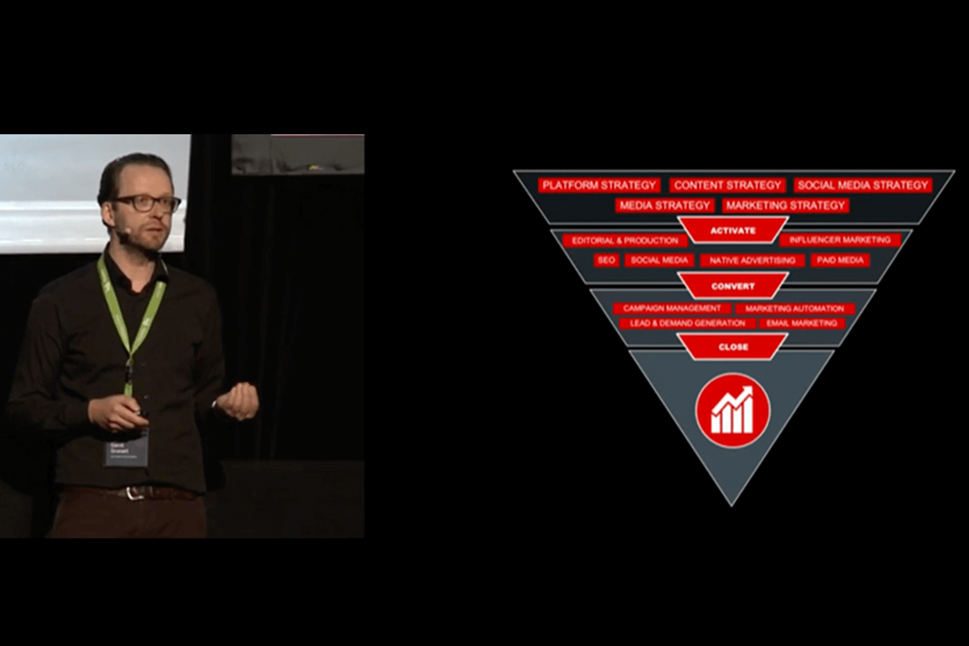

Diese Situation ist symptomatisch für die wachsende Komplexität in der Zusammenarbeit zwischen Agenturen und Unternehmen. Die steigende Geschwindigkeit in der Erstellung von Inhalten darf nicht zu Lasten der inhaltlichen Substanz gehen. Besonders bei strategischen Themen wie Markenpositionierung, Content-Strategie oder Kommunikationsplanung muss sichergestellt sein, dass KI-gestützte Tools korrekt eingesetzt werden.

Transparenz und Offenlegung als neue Standards

Der Vorfall hat deutlich gemacht, dass Offenheit im Umgang mit KI-Anwendungen zum Standard werden muss. In der Praxis bedeutet das: Wer KI-Tools zur Erstellung von Texten, Analysen oder Präsentationen einsetzt, sollte dies offenlegen. Branchenverbände, Medien und Wissenschaft fordern inzwischen klare Richtlinien und Transparenzpflichten. Die Überprüfung und Offenlegung der verwendeten Methoden wird zunehmend Teil des Qualitätsstandards.

Auch die Dokumentation von Quellen und Methoden gehört heute zu einer professionellen Arbeitsweise. Unternehmen, die von externen Agenturen Reports, Analysen oder Strategien beziehen, erwarten nachvollziehbare Prozesse und belastbare Ergebnisse. Die Offenlegung von KI-Einsatz, etwa in einem Methoden- oder Anhangsteil, reduziert nicht nur das Risiko von Fehlern, sondern stärkt auch das Vertrauen in die Zusammenarbeit.

Kritische Fehlerquellen und ihre Auswirkungen auf den Geschäftsalltag

Fehlerhafte Inhalte können weitreichende Folgen haben, von Imageschäden über finanzielle Verluste bis hin zu strategischen Fehlentscheidungen. Im beschriebenen Fall musste das Beratungsunternehmen einen Teil des Honorars zurückzahlen, zudem entstand ein enormer Reputationsschaden. Die Regierung prüft, ob und wie die Zusammenarbeit fortgesetzt wird. Auch im privaten Sektor führen vergleichbare Fehler zu Vertrauensverlust, Unsicherheiten und erhöhtem Kontrollaufwand.

Die Herausforderung liegt darin, KI-gestützte Prozesse so zu gestalten, dass sie in den Arbeitsalltag von Kommunikationsabteilungen und Agenturen integrierbar sind. Das betrifft Content-Erstellung, Research, Analyse und Präsentation. Fehlt die Kontrolle oder werden Fehler nicht erkannt, leidet die Qualität der Arbeit und damit die Wahrnehmung der Marke oder Organisation.

Innovative Methoden zur Risikominimierung und Qualitätssicherung

Um Risiken zu minimieren und Qualität zu sichern, setzen fortschrittliche Agenturen auf mehrstufige Prüfprozesse. Generative KI wird gezielt als Assistenzsystem eingesetzt, nicht als alleinige Quelle. Alle durch KI erstellten Inhalte werden durch menschliche Experten geprüft, validiert und gegebenenfalls angepasst. Dabei kommen strukturierte Checklisten, Quellenverifizierung und Peer-Review-Verfahren zum Einsatz.

Ein weiterer Ansatz ist die Entwicklung und Nutzung domänenspezifischer KI-Modelle. Statt generischer Systeme wie GPT-4 werden spezialisierte Modelle auf branchenspezifische Inhalte trainiert. Dies erhöht die Genauigkeit, reduziert das Risiko von Halluzinationen und verbessert die Nachvollziehbarkeit der Ergebnisse. In sensiblen Bereichen wie Recht, Finanzen oder Wissenschaft ist dies bereits gelebte Praxis.

Fallstudie: Die Fehler im Deloitte-Report und die Konsequenzen

Das Beratungsunternehmen Deloitte Australia veröffentlichte einen Report für das Department of Employment and Workplace Relations (DEWR), der später wegen gravierender Fehler in die Kritik geriet. Wissenschaftler entdeckten bis zu 20 falsche oder erfundene Zitate und Quellenangaben, darunter ein angebliches Buch von Professor Lisa Burton Crawford, das nicht existiert, sowie ein frei erfundenes Zitat aus einem Gerichtsurteil. Es stellte sich heraus, dass das Unternehmen bei der Erstellung auf das generative KI-Modell Azure OpenAI GPT-4o zurückgegriffen hatte (Quellen: ABC News, Yabble, Australian Financial Review).

Die KI-generierten Inhalte wurden zunächst nicht als solche gekennzeichnet. Erst nach öffentlicher Kritik und einer internen Überprüfung wurde der Bericht überarbeitet, fehlerhafte Passagen entfernt und der KI-Einsatz offengelegt. Deloitte erstattete einen Teil des Honorars (440.000 AUD) zurück. Die Regierung setzte die finale Zahlung aus und prüft die weitere Zusammenarbeit. In der Branche entstand eine Debatte über neue Standards für Transparenz, Offenlegung und Qualitätssicherung beim KI-Einsatz. Experten fordern nun verbindliche Prüfprozesse, Disclosure-Pflichten und den Einsatz spezialisierter KI-Modelle.

Erste Schritte für einen sicheren und transparenten KI-Einsatz

Um die beschriebenen Risiken zu vermeiden und die Qualität der eigenen Kommunikation zu erhalten, empfiehlt sich ein strukturierter Einstieg in den KI-Einsatz:

1. Klare interne Richtlinien entwickeln

- Definieren, in welchen Prozessen generative KI eingesetzt werden darf.

- Dokumentation und Offenlegung der KI-Nutzung festschreiben.

2. Menschliche Kontrolle sicherstellen

- Jeder KI-generierte Inhalt muss durch Fachexperten geprüft werden.

- Verantwortung für finale Ergebnisse bleibt beim Menschen.

3. Quellen und Zitate verifizieren

- KI-generierte Quellen und Zitate werden grundsätzlich nachrecherchiert.

- Keine ungeprüften Inhalte in Berichte oder Präsentationen aufnehmen.

4. Transparenz gegenüber Auftraggebern und Stakeholdern

- Offenlegung des KI-Einsatzes in Methoden- oder Anhangsteilen.

- Auf Wunsch Bereitstellung der Prompt-Historie oder KI-spezifischer Einstellungen.

5. Kontinuierliche Schulung und Sensibilisierung

- Teammitglieder regelmäßig zu neuen KI-Trends und Risiken weiterbilden.

- Awareness für KI-Halluzinationen und Fehlerquellen schaffen.

6. Einsatz von spezialisierten KI-Modellen prüfen

- Für besonders kritische Aufgaben domänenspezifische KI-Modelle verwenden.

- Zusammenarbeit mit Technologiepartnern für individuelle Lösungen.

Zukunftsfähige Kommunikationsprozesse durch Expertise und Methodenkompetenz

Agenturen, die auf eine Kombination aus kreativer Exzellenz, analytischer Kompetenz und Branchenfokus setzen, sind für die Herausforderungen der KI-gestützten Kommunikation besonders gut aufgestellt. Die Fähigkeit, innovative Methoden verständlich zu erklären, Trends zu identifizieren und transparent zu kommunizieren, schafft Vertrauen in der Zusammenarbeit. Wer die Mechaniken generativer KI transparent macht und Fachfremde für die Risiken sensibilisiert, stärkt die eigene Marke und unterstützt Kunden auf dem Weg zu einer nachhaltigen, sicheren und erfolgreichen Kommunikationsstrategie.

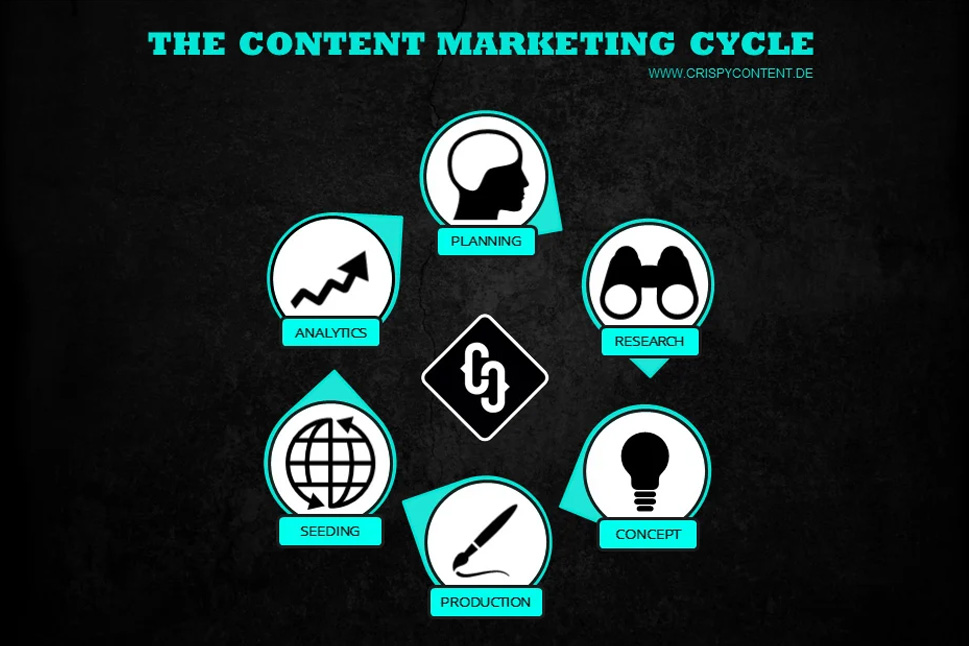

Kreativ, smart und kommunikativ. Analytisch, tech-savvy und zupackend. Das sind die Zutaten für einen Content Marketer bei Crispy Content® – egal ob er oder sie Content Stratege, Content Creator, SEO-Experte, Performance Marketer oder Themenspezialist ist. Unsere Content Marketer sind „T-Shaped Marketer“. Sie verfügen über ein breites Wissensspektrum gepaart mit tiefgehenden Kenntnissen und Fähigkeiten in einem einzelnen Bereich.

.png)

.jpg)

-1.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)