Google Update: der Wegfall von &num=100 und die Folgen

Zuletzt aktualisiert am 8. Oktober 2025 um 13:25 Uhr.Mit einem unscheinbaren Parameter haben viele SEO-Tools jahrelang eine der wichtigsten Regeln der Google-Suche elegant umgangen: Die Begrenzung auf zehn Ergebnisse pro Seite. Das kleine Anhängsel „&num=100“ im Such-URL ermöglichte es, 100 Treffer auf einmal abzurufen – eine enorme Arbeitserleichterung für alle, die große Mengen an SERP-Daten für Analysen, Monitoring und AI-Training benötigten. Doch der September 2025 brachte die Wende: Google schaltete diese Hintertür ab, ohne Vorwarnung, ohne Ersatz. Die Branche, die sich so sehr an das praktische Schlupfloch gewöhnt hatte, stand plötzlich vor einer radikalen Zäsur.

Von cleveren Umgehungen und deren Konsequenzen

Die Regel war eigentlich klar: Google zeigt zehn Ergebnisse pro Seite. Doch wer sich auskannte, wusste, wie sich mit einem simplen Zusatz deutlich mehr Daten auf einen Schlag abgreifen lassen. Es war ein stilles Agreement, ein nicht offiziell dokumentierter Trick und damit ein perfektes Beispiel für die kleinen, unausgesprochenen Regeln, die das tägliche Arbeiten mit der Suchmaschine prägen. Die SEO-Welt lebte mit diesem Workaround und baute ganze Geschäftsmodelle, Monitoring-Prozesse und Data-Pipelines darauf auf. Die Konsequenzen eines abrupten Endes von massiven Kostensteigerungen bis zu Datenverlusten waren bei vielen lange kein Thema. Bis jetzt.

Die Bedeutung umfassender SERP-Daten für Wettbewerbsfähigkeit

Viele Unternehmen und Dienstleister nutzten die Möglichkeit der breiten Datenabfrage, um die eigene Sichtbarkeit oder die des Wettbewerbs möglichst tiefgreifend zu analysieren. Sichtbarkeitsindizes, Marktbeobachtungen, AI-Trainingsdaten: All das basierte auf der Erfassung von möglichst vielen Rankings pro Suchbegriff. Das Ziel war, den eigenen Platz im Google Ranking nicht nur an der Oberfläche zu verstehen, sondern auch in den tieferen Rängen, die für Longtail-Traffic, Nischenmärkte oder Wettbewerbsanalysen entscheidend sind.

Präzision und Transparenz im Reporting geraten ins Wanken

Mit dem Ende der Möglichkeit, 100 Ergebnisse auf einmal abzufragen, werden die Karten neu gemischt. Die Tools müssen zehnmal so viele Anfragen stellen, um an die gleichen Daten zu kommen oder sie reduzieren die Tiefe ihrer Reports. Die Folge: Reports, die bislang die Top 100 Rankings abbildeten, zeigen künftig vielleicht nur noch die Top 20 oder 50. Strategische Entscheidungen verlieren an Präzision. Damit stellt sich die Frage: Wie lässt sich Transparenz und Datenqualität weiterhin gewährleisten, wenn die wichtigsten Datenquellen plötzlich weniger tief schürfen?

Technische Herausforderungen und wirtschaftliche Auswirkungen

Die technischen Auswirkungen sind erheblich. Monitoring- und Analyseanbieter wie Ahrefs, Semrush oder Sistrix mussten ihre komplette Infrastruktur anpassen. Zehnmal mehr Requests bedeuten höhere Serverlasten, gesteigerte Kosten und langsamere Aktualisierungen. Manche Anbieter berichten von kurzfristigen Ausfällen und fehlerhaften Reports in der Umstellungsphase. Dazu kommt: Wer den Zugriff auf tiefere Rankings weiter garantieren möchte, muss zahlen sei es in Form von eigenen Ressourcen oder durch den Einkauf alternativer Datenquellen.

Der Blick in die Tool-Landschaft: Wer reagiert wie?

Einige Anbieter reagieren flexibel und suchen nach Workarounds, andere reduzieren den Umfang ihrer Analysen. Ein prominenter Fall: Wie das US-Unternehmen GTMA Agency berichtet, wurden bei mehreren großen SEO-Tools die Reporting-Tiefen kurzfristig reduziert, um die gestiegene Last abzufedern. Im Hintergrund suchen Entwickler nach effizienten Scraping-Strategien, alternativen APIs oder Partnerschaften, die den Zugriff auf tiefere Daten wieder herstellen könnten. Der Markt für SERP-Daten befindet sich damit im Umbruch und wer zu langsam reagiert, riskiert Performance-Einbußen und Reputationsverluste.

Auswirkungen auf AI-Ökosysteme und Datenaggregation

Auch für die Entwicklung von Large Language Models (LLM) und generativen KI-Anwendungen hat das Google Update Folgen. Die Möglichkeit, große Mengen an Suchdaten schnell und günstig zu extrahieren, war für viele AI-Projekte ein wichtiger Baustein. Mit der neuen Begrenzung steigen die Kosten für Datenakquise, Trainings- und Updatezyklen werden langsamer. Wer weiterhin auf aktuelle, breite Suchdaten zugreifen möchte, muss neue Wege finden oder sich mit geringeren Datenmengen zufriedengeben.

Warum der Wandel nicht alle gleich trifft

Wer sich bislang auf automatisierte Massenabfragen verlassen hat, steht vor der Aufgabe, eigene Prozesse zu überdenken. Kleine Unternehmen, die auf günstige Standard-Tools setzen, bemerken die Veränderungen vielleicht erst spät wenn ihre Reports plötzlich weniger umfangreich ausfallen oder Rankings scheinbar „verbessert“ werden, weil tiefe Platzierungen schlicht nicht mehr erfasst werden. Datengetriebene Marketing- und Analyseabteilungen hingegen merken den Unterschied sofort: Sie verlieren Einblick in die unteren Ränge, wo oft relevante Nischenthemen und neue Wettbewerber auftauchen.

Ein Blick hinter die Kulissen: Der GTMA-Agency-Case

Die GTMA Agency beschreibt beispielhaft, wie einschneidend die Änderungen für datengetriebene Marketer sein können. Direkt nach der Deaktivierung der „&num=100“-Abfrage verzeichneten sie einen drastischen Rückgang der Impressions in der Google Search Console: Die Zahl der ausgewiesenen Rankings brach ein, weil der Bot nicht mehr wie gewohnt die unteren Positionen erfassen konnte. Gleichzeitig schien sich die durchschnittliche Ranking-Position zu verbessern ein Trugschluss, denn tatsächlich fehlte nun einfach ein Großteil der Daten. Die Agentur musste kurzfristig die eigene Reporting-Infrastruktur anpassen, die Kommunikation mit Kunden neu aufsetzen und alternative Datenerhebungsmethoden testen. Nach mehreren Wochen und zusätzlichen Investitionen gelang es, die Reports wieder auf ein akzeptables Niveau zu heben.

Neue Methoden und innovative Lösungsansätze

Die Branche steht an einem Wendepunkt. Statt auf klassische Scraping-Techniken zu setzen, rücken alternative Methoden in den Fokus: Partnerschaften mit Datenanbietern, KI-gestützte Schätzverfahren, die Kombination verschiedener Quellen oder der gezielte Aufbau eigener Datenpools. Auch im Bereich der AI-Entwicklung entstehen neue Ansätze, um mit weniger, aber dafür qualitativ hochwertigen Daten zu arbeiten. Entscheidend ist, die eigene Strategie flexibel zu halten und frühzeitig in technologische Innovationen zu investieren.

Handlungsempfehlungen für Unternehmen

Wer im Google Ranking weiterhin eine entscheidende Rolle spielen und fundierte Entscheidungen treffen möchte, sollte folgende Maßnahmen ins Auge fassen:

Prozesse und Tools auf den Prüfstand stellen

- Bestehende Monitoring- und Reportingprozesse regelmäßig evaluieren

- Anbieter auswählen, die auf die neue Datenlage reagieren und transparent kommunizieren

- Eigene Datenquellen und Schnittstellen identifizieren und ggf. ausbauen

Technische und wirtschaftliche Auswirkungen analysieren

- Kosten-Nutzen-Verhältnis der aktuellen Tools hinterfragen

- Alternative Datenquellen und Partnerschaften prüfen

- Investitionen in KI und Data Science in die Budgetplanung aufnehmen

Neue Wege im Umgang mit Daten etablieren

- Kreative Methoden zur Datenaggregation entwickeln

- Interne Kompetenzen im Bereich Datenanalyse und KI stärken

- Trends im Bereich Google Update und Search Data Policy beobachten und proaktiv reagieren

Warum Expertise und Kreativität jetzt zählen

In einer Phase, in der bisherige Regeln außer Kraft gesetzt werden, sind Anpassungsfähigkeit und Branchenwissen wichtiger denn je. Die Veränderungen beim Google Update zeigen: Wer sich auf bestehende Prozesse verlässt, riskiert Blindspots und Wettbewerbsnachteile. Unternehmen, die Kreativität und analytische Kompetenz verbinden, erschließen neue Wege und sichern sich so einen nachhaltigen Vorsprung, auch wenn Google die Spielregeln erneut ändert.

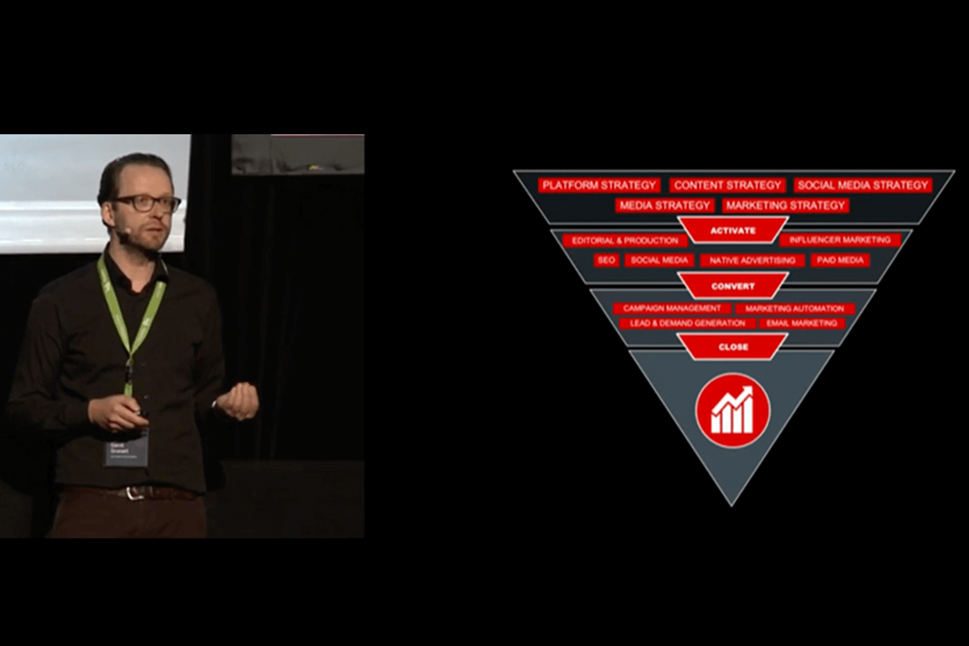

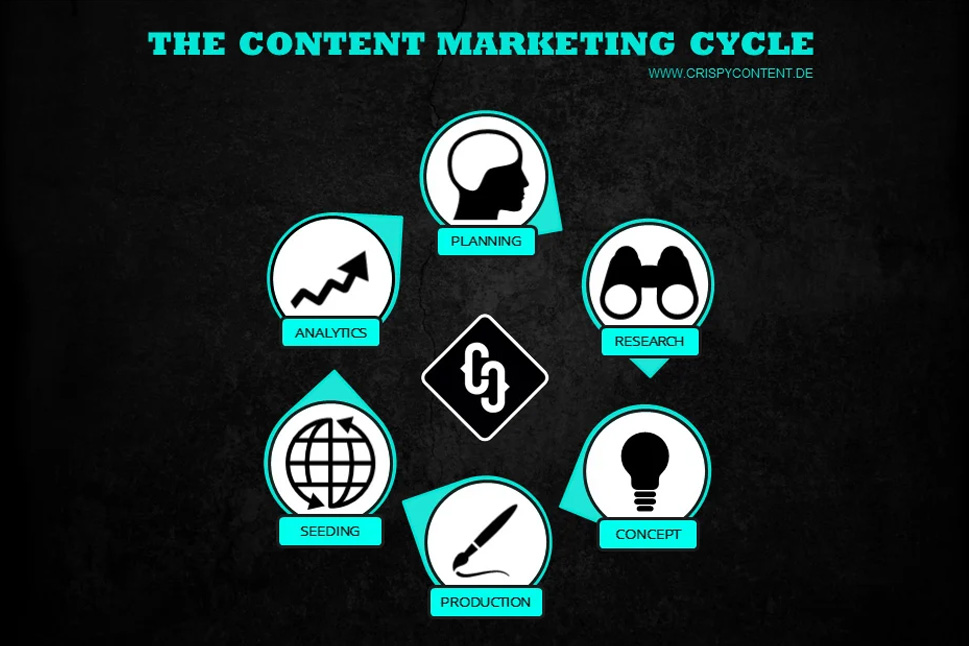

Kreativ, smart und kommunikativ. Analytisch, tech-savvy und zupackend. Das sind die Zutaten für einen Content Marketer bei Crispy Content® – egal ob er oder sie Content Stratege, Content Creator, SEO-Experte, Performance Marketer oder Themenspezialist ist. Unsere Content Marketer sind „T-Shaped Marketer“. Sie verfügen über ein breites Wissensspektrum gepaart mit tiefgehenden Kenntnissen und Fähigkeiten in einem einzelnen Bereich.

.png)

.jpg)

-1.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)